機関誌『ロボット』(一般社団法人日本ロボット工業会発行) No.280 2024.9 特集−AI技術とロボット

高木 啓伸(日本科学未来館/日本アイ・ビー・エム株式会社)

村田 将之(日本アイ・ビー・エム株式会社)

佐藤 大介(カーネギーメロン大学)

買い物やレストランでの食事や,学校や文化施設への通学など,公共交通機関やその他の公共の場所での移動を伴う活動は,私たちの社会生活において重要な部分を占めている。しかし視覚障害者は,障害物や曲がり角,歩行者,標識など公共の場にある視覚情報を得ることが難しいため,こうした移動が困難である。移動中に偶然見つけた店に立ち寄るといった都市環境を楽しむ行動はさらに難しい。

これまで,視覚障害者の移動をサポートする様々な方法が歴史的に開発されてきた。白杖は壁や障害物,目印を確認することができるため広く使われている。白杖を用いることで慣れた道を移動することはできるが,知らない場所を訪れることは難しい。盲導犬は障害物を避けたり,曲がり角を指示に従って曲がったりする訓練を受けているが,目的地や道順を理解しているわけではないため,ユーザ(視覚障害者)が方向を判断する必要がある。こうした限界がある中で,白杖と盲導犬は長い間,視覚障害者の移動を支えてきた。

近年,スマートフォンを利用した視覚障害者向けナビゲーションアプリの開発が急速に進んでいる。例えば,NavCog(1) はBluetooth® LE ビーコンと加速度センサを組み合わせた屋内測位(精度1. 5m 程度)に基づくターンバイターンナビゲーションを実現している。Wi-Fi® やビーコンを使った測位は環境側に機器設置が必要であるのに対し,画像処理を用いる方法は初回のデータ収集のみで環境構築が可能である。しかし,画像処理は時間帯や場所による視認性の変化や消費電力の増加などの課題がある。スマートフォンを介した音声による方向指示の理解度には個人差があり,時計方式も面倒で距離の特定が難しい。オーディオARは高精度測位技術と3Dオーディオ技術を組み合わせ,「ここに来てください」といったナビゲーションを実現できるが(2),音による空間認知能力には個人差があり,高精度な測位が必要である。また,認識技術を組み合わせた「スマート白杖」の開発も数多く進められているが,白杖に取り付け可能なセンサの大きさに限界があるため,実用化されたものは少ない。

一方,盲導犬ロボットを含むナビゲーション・ロボットには,視覚障害者が自立的に目的地まで到達できるという利点がある(3), (4),(5)。他の既存の方法と比較して,認知的負荷が少なく楽に移動できることも大きな利点である。しかし,コンセプトとしては数多く提案されているものの,そのほとんどは研究開発の段階に留まっており,実証実験に進んでいるものはほとんどない(6)。困難なのは,公共施設の広さにおいて十分な時間動作可能なロボットを,実用的なコストで生産することである。結果として,現在まで本格的に実用化されたナビゲーション・ロボットはない。

こうした課題を解決するために,スーツケースを模したナビゲーション・ロボット「AIスーツケース」を開発してきた。これは,ユーザが選んだ目的地へ自律的に移動し,視覚障害者を誘導するロボットである。日本科学未来館(以下,未来館)をはじめ,空港やショッピングモールにおいて実験やデモンストレーションが行われ,ハードウェアとソフトウェアの改良が続けられてきた。

AIスーツケースの研究開発は,2017年に米国カーネギーメロン大学で始まり,2020年より実用化を目指して企業を中心に大学などが参加したAIスーツケースコンソーシアムによって進められている。スーツケース型にする理由の一つは,人間工学的に優れたデザインにある。帯同しての歩行が容易であり,ユーザの一歩前を移動することで障害物に先に接触し,ユーザが安心してついて歩くことができる。また,スーツケースを持って歩くのは一般的な光景であり,都市環境に自然に溶け込めるという利点もある。

なお,実用化においてコストは大きな課題である。そこで,階段や大きな段差を乗り越える機能を搭載しないデザインとした。階段や大きな段差に対応するためには四足歩行など複雑で高価な機構が必要となる。

そのため,最低限必要な歩道と車道の間の3cm 程度の段差を乗り越える駆動機構に留め,それより高い段差はユーザが持ち上げて乗り越える設計とした。一方で,社会実装に向けて安全性を優先し,豊富なセンサと演算能力を搭載することで,障害物や歩行者を効果的に回避することを目指した。

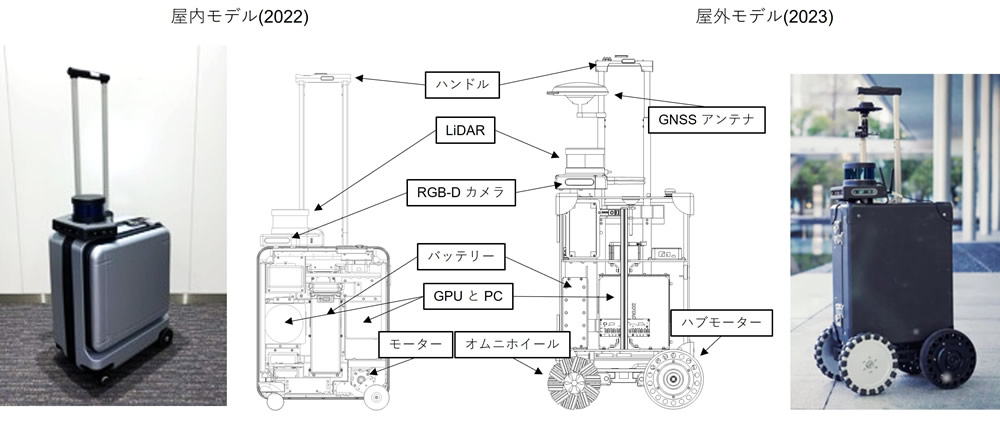

こうして,いくつかのモデルが開発されてきた。図1 は,2022年に開発された屋内モデルと2023年に開発された屋外モデルの基本システムである。本体は飛行機に持ち込めるサイズの市販のスーツケースから,四輪かつ内部をフレームで補強できる製品を選択した。

図1 AIスーツケースの概観と構造

目的地選択や音声案内などの主なインタフェースとして,スマートフォンを使用している。3種類の操作方法をメニューから選ぶことができ,一つ目は音声で会話しながら目的地を選択する「会話開始」,二つ目はアプリの標準操作で選択メニュー画面から目的地を選ぶ「目的地選択」である。三つ目の「ツアー選択」では,ロボットがユーザを一連の目的地,例えば博物館の一連の展示物などに案内する「ツアー」を選択できる。

ハンドルの下にはタッチセンサが配置され,ハンドルに触れているときだけスーツケースが動く仕組みとなっている。つまり,ユーザはハンドルを離すと自然な動作でスーツケースを停止させることができる。さらに,ハンドルの上部と両側面の3か所に振動子が設置されている。開発初期の実験で,ロボットが誘導中に急に曲がると,ユーザが不安を感じることが分かった。そこで,曲がる前に振動で曲がる方向を知らせる仕組みを導入した。

ロボットの自律移動とユーザへの情報提供のために,3種類の地図情報を作成・使用している。

一つ目はトポロジカルな「ルートマップ」で,目的地までの移動経路の情報を管理する。

ルートマップは,目的地や交差点を示すノードが,経路を示すエッジで結ばれたグラフ構造となっている。

二つ目の地図は「POI( Point of Interest )地図」である。POIとは,ナビゲーションエリア内にある施設のことで,建物,店舗,レストラン,看板,トイレ,案内所などを指す。ロボットはこのPOIマップを基に周辺環境を説明するため,POIマップの充実は移動を楽しいものにするために重要である。

三つ目は測位のためのLiDAR( Light Detection and Ranging)の点群と電波強度地図である。まず,センサを搭載したスーツケースを移動させながら,LiDAR点群,IMU(慣性計測装置),Wi-FiやBluetooth LEのRSS(受信信号電波強度)データを収集する。このデータを基に,高精度なLiDAR点群地図と電波強度地図を作成する。位置推定の際には,測定したRSSを電波強度地図と照合しておおよその位置を特定し,LiDAR点群を用いて数cm~10cmの精度で姿勢を推定する。AIスーツケースは空港や商業施設など,複数階の広い環境で使用されるため,RSSと高度計を利用して階を切り替える機能や,広いフロアを分割してマッピングする機能も備えている。

屋外での測位には,LiDARとIMUをRTK( Real-Time Kinematic )と組み合わせて使用している。RTKは高精度な衛星測位技術の一つで,cm単位の精度で位置情報を得ることができる。屋内外境界付近での屋内地図と屋外地図の切替えは,推定した位置及び衛星信号の受信状況に基づいて行われる。

動く歩行者や障害物をリアルタイムに認識するためにコストマップを用いている(7)。コストマップは,ロボットが移動するための「コスト」を空間的にマッピングしたもので,障害物や危険なエリアは高コスト,安全で移動しやすいエリアは低コストとして表現される。測位にも使用されるLiDARセンサは,周囲の障害物を点群データとして常時計測している。このデータにより,周囲の環境に応じて常にコストマップを更新し,衝突をできるだけ避けたルートが選択される。さらに,3台のRGB-Dカメラ(深度センサ)を採用し,周囲の歩行者を画像認識している。認識した歩行者の位置・移動方向・速度をロボットの速度制御に用いることで,安全性を高めている。

未来館を含むAIスーツケースコンソーシアム参加組織は,2020年より技術デモンストレーションや実証実験を行い,2024年3月までに延べ900人近い参加者がAIスーツケースを体験してきた。これらの実証を通して,屋内走行モデルに関してはハードウェアとソフトウェアの両面において実用性が十分に向上したことを確認できた。これにより,次の段階として未来館における実証運用を開始することとなった。

未来館は,7階建ての建物の中に11,000m2の展示フロアを持つ日本を代表する科学館であり,未来の技術をいち早く来館者が体験できる場「未来社会の実験場」となることを目指している。そのため,未来館にとってAIスーツケースは,人を支援するロボットが社会に実装された未来を体現し,来館者に提示できる存在である。また,視覚障害者には自立した来館体験を提供することができる。さらに一般の来館者には,フロアでの動きを目にしたり,目を閉じてAIスーツケースを体験したりすることで,人を支援する自律ロボットに対する心理的障壁を下げるとともに,社会実装の課題を考える題材となり得る。

ツアールートは2種類準備した。

①「プラネタリークライシス」をめぐるツアー

昨年より公開しているもので,気候変動に直面している地域の現状を体感するシアター,世界の平均気温の上昇や各国のCO2排出量などを触って体験できる展示などがある「プラネタリークライシス」という展示エリアを体験するツアー。科学館体験を希望する視覚障害のある参加者に適している。所要時間は25分から40分程度。

②自由選択ツアー

常設展内にある約20の展示エリアから三つ程度を選んでめぐるツアー。

興味がある展示が既に存在する場合や,AIスーツケースによるナビゲーション体験を主軸に短い時間での体験を希望する参加者に適している。所要時間は15分から20分程度。来館者は,館内を移動しながら次に向かう展示の概要を音声で聞くことができる。また,到着時にはその空間構成や触れる展示の有無などを含むより詳しい説明が音声で流れる。

2024年4月18日の開始から7月31日までに714人の方がAIスーツケースを体験した。このうち約4分の1が視覚障害者と推定される。表1と表2に6月30日までのアンケート結果を示す。複数人で体験し,代表者のみがアンケートに回答している場合があるため,回答数は体験人数と一致していない。視覚障害者は全盲,弱視,ロービジョンなど明確に視覚障害者であることを回答した件数であり,晴眼者はそれ以外(コンタクト,メガネなどを含む)である。

表1 からは,視覚障害者の83%,晴眼者の94%が「とても満足した」もしくは「満足した」と回答したことが分かる。

満足と回答した方からは,展示物を自由に選択し,単独で移動できることに好意的な意見が寄せられ,「早く実用化して欲しい」という意見が多数あった。

「不満」もしくは「とても不満」と回答した理由のうち技術的に解決可能なものとしては,「走行途中で停止したときの説明がなく不安になった。」,「ハンドルのボタンが押しづらかった。(70代以上)」などがあった。担当者の説明不足などの問題は順次改善している。

| とても不満だ | 不満だ | どちらともいえない | 満足した | とても満足した | 合計 | |

|---|---|---|---|---|---|---|

| 視覚障害者 | 0 | 4 | 11 | 32 | 42 | 89 |

| 0% | 4% | 12% | 36% | 47% | ||

| 晴眼者 | 2 | 1 | 11 | 77 | 146 | 237 |

| 1% | 0% | 5% | 32% | 62% |

表2からは,視覚障害者の71%,晴眼者の79%が「とても安心・安全と感じた」もしくは「安心・安全と感じた」と回答したことが分かる。安心・安全と感じた方からは以下のようなコメントがあった。

一方で危険・不安と感じた方は,「人が多いところで進まなくなる。加減速が多い。」が主要な理由であった。この意見は安心・安全と感じた方からも寄せられている。混雑時の動作と停止した場合の情報提供を改善する必要がある。

| とても危険・不安と感じた | 危険・不安と感じた | どちらともいえない | 安心・安全と感じた | とても安心・安全と感じた | 合計 | |

|---|---|---|---|---|---|---|

| 視覚障害者 | 0 | 6 | 19 | 36 | 28 | 89 |

| 0% | 7% | 21% | 40% | 31% | ||

| 晴眼者 | 0 | 12 | 38 | 127 | 60 | 237 |

| 0% | 5% | 16% | 54% | 25% |

定常運用と並行して屋外走行モデルを開発し,実証実験を行った。屋外モデルでは,前輪後輪ともに20cmの大径ホイールを採用することで,3cm程度の歩道と車道の間の段差の乗り越えを実現している(図1)。

東京都の協力の下,2023年1月と9月に未来館と最寄り駅を結ぶ公園内の歩道及び横断歩道にて実証実験を行った。ルートは,信号のない2車線道路の横断歩道を含む全長400mである。2023年1月の第1回目のルートは屋外のみで,9月の第2回目のルートは屋内から屋外(未来館から公園),屋外からエレベータ(公園から駅)への移動であった。20人の視覚障害者が1月の実験に参加し,14人が9月の実験に参加した。

9月の実験では,システムユーザビリティスケール(SUS)を測定した。参加者14人の平均点は83.2点であり,受容性では「可」,評点では「B」,形容詞評価では「優」と解釈することができる。最低は64点,最高は100点であった。また,歩道と車道の間の段差の乗り越え,横断歩道の横断,エレベータの乗り降り,障害物の回避,歩行者の回避などについても安心感や快適性を尋ねた。最も評価が低かったのは,歩道と車道の間の段差乗り越えと横断歩道の横断(それぞれ平均3.5, 3.4)であった。20cm の大きな車輪を装着していても,段差を乗り越える挙動が不安定で止まってしまうことがあった。また,速度を上げると段差に到達したときの衝撃で不快感を与えてしまうことが分かった。一方,障害物回避や歩行者回避,ハンドルの振動サインは,屋内環境と同様に平均4.5~4.7点と良好に動作した。

ここでは,未来館での運用だけでなく,一連のデモンストレーションや実証実験を通じて見えてきた幅広い分野にまたがる課題を概観する。

ナビゲーション・ロボットの目的の一つは,視覚障害者が都市環境を楽しめるように店舗や施設の周辺情報を提供することである。Webデータを基に静的なPOI情報を作成したが,これだけではユーザの要望に対応できなかった。例えば,未来館では展示の詳細な説明が求められたが,その情報はWeb上にはなく,展示物に詳しいスタッフが作成する必要があった。このデジタル情報と実際の都市環境の情報密度の差を埋めるためには,人手だけでなく視覚言語モデル(8)などの技術も必要である。

4. 3節で述べたように,未来館での定常運用での最も大きな課題は混雑した環境への対応である。現在のロボット技術は,歩行者で混雑した環境での誘導が困難である(9)。基本的な戦略は,安全に配慮して一時停止を行うことであるが,このような一時停止は通行を妨げ,近隣の歩行者に不安を与える可能性がある。そのため,歩行者の流れに合わせて移動する新たな技術などが必要である。

日本のように特に公共空間での規律が重んじられる地域では,行列に割り込まずに整列するといった,社会的に許容される行動をとることが不可欠である。そのため,社会的距離を保って列に並ぶ機能などを実装した。ルートマップ上の待ち行列になりそうな場所にあらかじめメタデータを作成しておくことで,ロボットが待ち行列モードに切り替わることを可能にしている。今後はリアルタイムで行列など周囲の状況を認識し,規律ある行動を行う技術が必要である。

現行の屋外ナビゲーションモデルでは,大きな車輪を装備することで屋外での段差乗り越えに対処しようとしたが,ユーザに不安を与える原因となってしまった(第5章)。さらに,都市の屋外環境では,摩擦係数の異なる路面,タイル,マンホール,鉄の網目など屋内にはない課題があり,改善が必要である。

AIスーツケースの運用は現在,あらかじめ地図が作成された環境に限定されており,その地図を作成するために多大な労力を必要とする。この制限により,実用的な配備はレンタルモデルの大規模な公共施設に限定されている(6. 4節)。自由な移動を可能にするという目標を達成するためには,未知の場所でも地図を生成しながら誘導できる技術が必要である。Pathfinder(10)はAIスーツケースを使用し,リアルタイムのLiDARスキャン,コンピュータビジョン,OCR技術を通じて交差点や標識の情報を認識することで,地図にない場所でのナビゲーションを可能にしている。この技術は現在のところ,特定の環境に限定されているが,ナビゲーション・ロボットの運用可能エリアを拡大するために必要な技術である。

スーツケース型のデザインの狙いの一つは,前述のように視覚障害者が目立つことなく公共の場を移動可能となることである。白杖など現在の支援機器を用いていると必然的に目立ってしまうため,視覚障害者の中には目立たずに公共の場を移動したいと考えている人がいる。しかし逆に,目立つことで周囲の人々に自分の存在を知らせる方が快適で安全だと感じている人が多いことも,これまでの調査の結果分かってきた。この考え方は,公共空間を視覚障害者が単独で歩行する場合に,白杖もしくは盲導犬の使用を義務付けている日本の道路交通法にも則している。AIスーツケースにとって,両方の視点に対応することが重要である。

今後の社会実装に向けては,「高度なロボット技術があっても,視覚障害者が公共の場で目立つべきなのか?」という問いについて社会的な議論を進める必要がある。ナビゲーション・ロボットがあれば,視覚障害者は障害物や歩行者を避けることができ,道に迷うこともない。この新しい技術が普及し,視覚障害者のコミュニティから信頼され始めると,規制を含む社会のルールが変わる可能性がある。

顔認識技術を利用することで,視覚障害者は知人が近付いてきたときに認識できるようになる。しかし,公共の場での顔認識技術の利用は,社会的に受け入れられていないという課題がある。プライバシーに関する懸念は大きいが,逆に,同技術は人々の日常生活を向上させる可能性を秘めている。

AIスーツケースはエレベータの乗降が可能であるが,エレベータを呼び出したり,目的階を選択したりする機能はない。利用者は,約1. 5m先にあるエレベータのボタンを探し,目的の方向に合ったボタンを押すことが求められるが,実際にはボタンを探すために時間がかかることがあり,ユーザの負担となっている。実用化のためには,ロボットはユーザの介入を必要とせずにエレベータを制御する能力を持つべきであろう。日本では,エレベータを操作する屋内自律サービスロボットの規格が議論されており,試験も進行中である(11)。

歩行者信号の横断は,屋外ナビゲーションのもう一つのハードルとなる。車両用道路信号を自動運転自動車に通知する通信技術の標準化は進んでいるが,歩行者用信号の標準化は遅れている。当面,信号の色を認識するためのコンピュータビジョン技術への依存は避けられない。インターネットやローカルネットワークを介してロボットに信号の色を確実に伝え,横断歩道での安全な横断を可能にするインフラが強く求められている。こうしたインフラは,宅配ロボットをはじめとする他のサービスロボットにとっても極めて重要である。

購入してロボットを所有するという個人販売は分かりやすいが,価格面と技術的な制限(地図にない場所を移動できないなど)のため,当面困難であろう。もう一つの可能性として注目されているのが公共施設での「レンタルモデル」である。例えば空港では,旅行者をゲートまで自律的に誘導することで,ユーザ体験を向上させ,ショッピングなども可能にすることができる。未来館における定常運用は,こうしたレンタルモデルによる社会実装の第一歩にほかならない。これにより視覚障害のある来館者へのサービス向上と,一般来館者への近未来体験提供を実現することができる。運営者と利用者の双方にとって有益なユースケースの創出が,社会実装の原動力となることが期待される。

本稿では,視覚障害者のために設計されたナビゲーション・ロボット「AIスーツケース」の技術を概説し,日本科学未来館での定常運用や屋外走行のための実証実験を紹介した。また,それらの経験を通して明らかとなった実用化のための課題を整理した。AIスーツケースは新聞やテレビなど多くのメディアから注目を集め,2024年6月には官邸にて岸田総理に体験いただいた。2025年の大阪・関西万博に向けては,国からの支援を受けて大規模実証実験の準備を進めている。このように実用化に向けた道筋を着実に歩んでいるが課題も多い。本稿がナビゲーション・ロボットの社会実装の一助となることを願っている。